在前几篇文章中([搜房网房产数据采集程序demo--GeckoWebBrowser实例] )都有提到一个解析html的C#类库HtmlAgilityPack,

今天终于有时间整理一下,并把Demo分享一下。

HtmlAgilityPack是一个基于.Net的、第三方免费开源的微型类库,主要用于在服务器端解析html文档(在B/S结构的程序中客户端可以用Javascript、jquery解析html)。截止到本文发表时,HtmlAgilityPack的最新版本为 1.4.6。下载地址:http://htmlagilitypack.codeplex.com/。最新版本支持Linq to Objects ( LINQ to Xml ).

准备:

如果你有安装Nuget的话,可以直接查找安装即可。

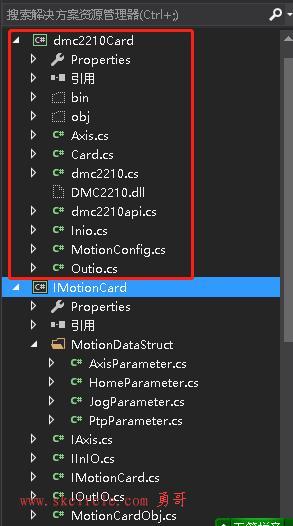

下载后解压缩后有3个文件,这里只需要将其中的HtmlAgilityPack.dll(程序集)、HtmlAgilityPack.xml(文档,用于Visual Studio 2008中代码智能提示和帮助说明之用)引入解决方案中即可使用,无需安装任何东西,非常好用。

在C#类文件开头引入using HtmlAgilityPack;就可以使用该命名空间下的类型了。实际使用中,几乎都是以HtmlDocument类为主线的,这一点非常类似于微软.net framework中的XmlDocument类。XmlDocument类是操作的是xml文档,而HtmlDocument类操作的是html文档(其实也可以操作xml文档),它们的操作方式都是基于Dom,所不同的是后者取消了诸如GetElementsByTagName这样的方法,强化了GetElementById方法(在HtmlDocument中可以直接使用,而XmlDocument则不可以)。

HtmlAgilityPack中定位节点基本上都用Xpath表达式,Xpath表达式的参考文档可见:http://www.w3school.com.cn/xpath/xpath_syntax.asp。自行学习。

不过可以先用几个简单就可以。比如,我们用到最多可能就是针对某个元素(div)、或者某个class属性的div、或者某个id的div,或者以什么开头的div,

类似这样的Xpath还是比较简单的。

Xpath举几个例子,下面的代码中我们就会用到:

"//comment()"在XPath中表示“所有注释节点”

1、获取网页title:doc.DocumentNode.SelectSingleNode("//title").InnerText; 解释:XPath中“//title”表示所有title节点。SelectSingleNode用于获取满足条件的唯一的节点。

2、获取所有的超链接:doc.DocumentNode.Descendants("a")

3、获取name为kw的input,也就是相当于getElementsByName(): var kwBox = doc.DocumentNode.SelectSingleNode("//input[@name='kw']");

解释:"//input[@name='kw']"也是XPath的语法,表示:name属性等于kw的input标签。

//li/h3/a[@href]:所有li下面的h3包含a超级链接有href属性才符合。有的a可能是支持的js事件

//div[starts-with(@class,'content_single')]:所有符合条件的div,并且它的class是由字符串content_single 开头的。//标示获取documet下的所有符合条件。/div标示从根目录开始的符合条件的。

以上是准备工作。下面说一下HtmlAgilityPack读取web页面,并解析的方法步骤。

1.读取url:

HtmlAgilityPack.HtmlWeb hw = new HtmlAgilityPack.HtmlWeb(); HtmlAgilityPack.HtmlDocument doccc = hw.Load(url);//是你需要解析的url ArrayList ImagePtahs = GetHrefs(doccc);

这里可能会遇到2个问题。

一个是编码问题,一个是gzip不支持的问题。

首先编码问题解决办法:就是不用HtmlAgilityPack去获取Url的data数据,自己获取了。大家可能就问了:我自己获取了他不给我解析那?

没事,他不会那么笨的。谁的肉不是吃啊?

方法如下:

WebProxy proxyObject = new WebProxy(IP, port);//这里我是用的代理。

//向指定地址发送请求

HttpWebRequest HttpWReq = (HttpWebRequest)WebRequest.Create(url);

HttpWReq.Proxy = proxyObject;

HttpWReq.Timeout = 10000;

HttpWebResponse HttpWResp = (HttpWebResponse)HttpWReq.GetResponse();

StreamReader sr = new StreamReader(HttpWResp.GetResponseStream(), System.Text.Encoding.GetEncoding("UTF-8"));

//注意上面的编码了吗??

HtmlAgilityPack.HtmlDocument doc = new HtmlAgilityPack.HtmlDocument();

doc.Load(sr);

int res = CheckIsGoodProxy(doc); //这是我解析的函数,还没到那一步。不解释了。

sr.Close();

HttpWResp.Close();

HttpWReq.Abort();另一个问题就是很奇怪了。gzip的问题开启了gzip压缩的网页请求时会报错。报错信息为“gzip”不是受支持的编码名。

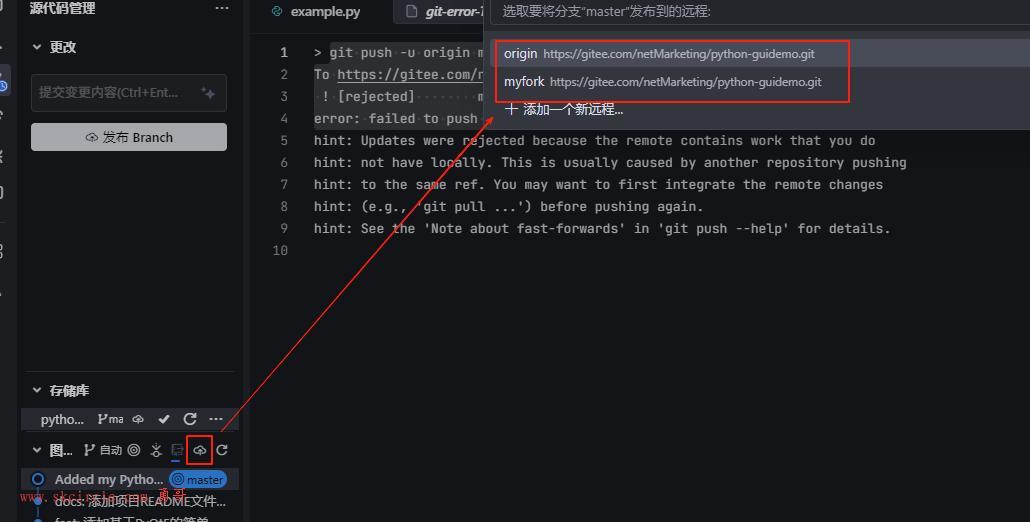

在谷歌上搜索了半天,终于找到解决方案,而且不必更换HttpRequest或WebClient进行请求。同时还可以用此方法设置cookie,render伪装等等。。。

解决后代码如下:在你发起请求的是修改一下。

HtmlWeb webClient = new HtmlWeb();

HtmlAgilityPack.HtmlWeb.PreRequestHandler handler = delegate(HttpWebRequest request)

{

request.Headers[HttpRequestHeader.AcceptEncoding] = "gzip, deflate";

request.AutomaticDecompression = DecompressionMethods.Deflate | DecompressionMethods.GZip;

request.CookieContainer = new System.Net.CookieContainer();

return true;

};

webClient.PreRequest += handler;

HtmlDocument doc = webClient.Load(this.getUrl());可能最新版本的HtmlAgilityPack会修复这个问题吧。期待中。

2.用Xpath解析。

这一步就比较简单了。就用Xpath选出你想要的数据,遍历他们,取出他们的value即可。

实例代码:

private ArrayList GetHrefs(HtmlAgilityPack.HtmlDocument _doc)

{

try

{

Images = new ArrayList();

HtmlNodeCollection hrefs = _doc.DocumentNode.SelectNodes("//li/h3/a[@href]");

HtmlNodeCollection hrefs2 = _doc.DocumentNode.SelectNodes("//div[starts-with(@class,'content_single')]");

if (hrefs == null)

return new ArrayList();

foreach (HtmlNode href in hrefs)

{

// Images.Add(href.Attributes["src"].Value);

string hreff = href.Attributes["href"].Value;// 排除 博海拾贝第二百零二期】吃完薯条寂寞了

string title = href.Attributes["title"].Value;

if (title.IndexOf("邪恶") >= 0)

{

continue;

}

if (title.IndexOf("恶搞") >= 0)

{

continue;

}

if (title.IndexOf("雷人") >= 0)

{

continue;

}

///执行数据保存的逻辑

}

}

catch (Exception ex)

{

ShowLogMsg("出错了:"+ex.Message+ex.StackTrace);

return new ArrayList();

}

}每一个Htmlnode,你要获取他的数据用这个方法: img.Attributes["src"].Value

少有人走的路

少有人走的路