[置顶]python知识导航贴,持续更新

[置顶]C++相关导航贴,持续更新

[置顶]本站连载贴子系列,持续更新中……

[置顶]勇哥的免费视频教程清单

[置顶]勇哥在B站发布的视频清单

[置顶]运动控制专题,持续更新

- 会员中心

- 搜索

- 网站分类

-

- .net程序调试

- 系统架构师

- Remoting

- 消息队列

- WCF/SOA

- C#高级话题

- Xamarin和MAUI

- WinUI3

- asp.net

- 网站前端框架

- webApi

- jQuery

- WebService

- Node.js

- .net core

- MEF

- asp.net core

- EFCore

- blazor

- Canvas

- SignalR

- gRPC

- 源生成器

- web端技术

- 驱动开发

- java

- 工业仿真

- 云计算

- 大数据

- 物联网/工业互联网

- 区块链

- 人工智能

- 虚拟现实和增强现实

- solidworks

- 行业示例源码和资源

- 大模型相关

- 本站开源软件与资源

- 自定义控件

- 本站原创软件与资源

- OSGI.NET

- Workflow

- 杂七杂八的文章

- 网页自动化技术

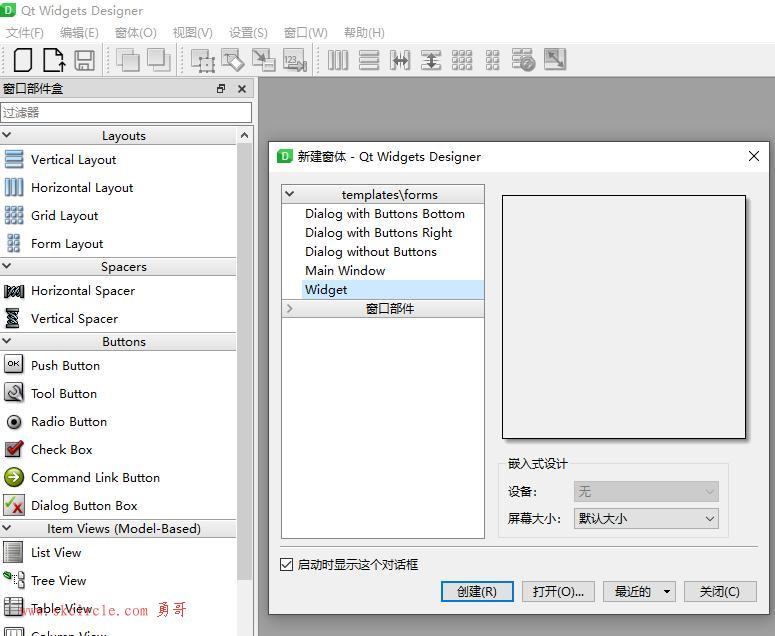

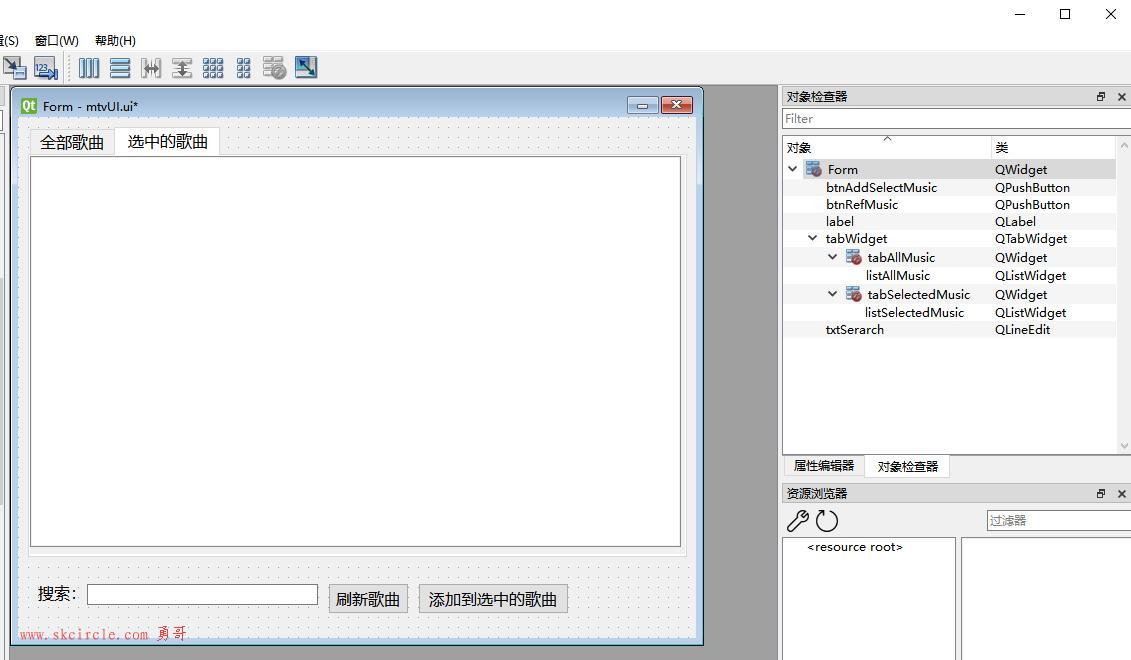

- c++/QT/MFC

- 机器人/手眼标定

- 理财知识

- 视觉实验

- netMarketing类库说明档

- 电气与3D图

- OpenCV

- 数据库

- Matlab

- C#/.net框架

- C# 异步编程

- C# TPL

- C#事件与委托

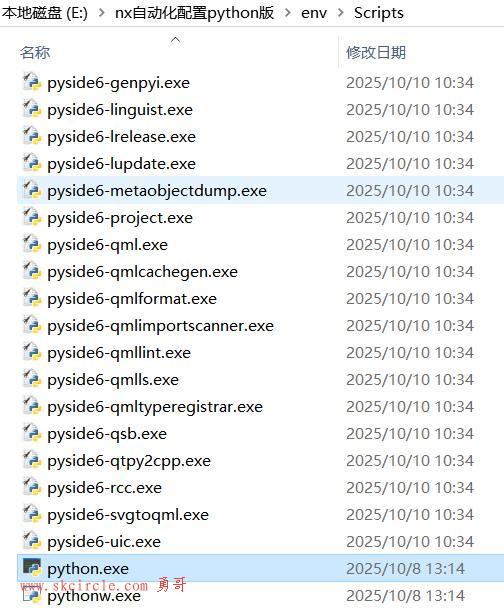

- python

- 工业视觉/halcon

- 面向对象/设计原则/设计模式/代码重构

- 安卓、IOS、Xamarin 开发

- 版本控制

- 哲学与人生

- PLC和单片机技术

- VisionPro

- 行业软硬件

- 行业算法与知识

- 行业新闻与工作经验

- WPF

- 生活记事本

- 分类器、神经网络、深度学习

- 工业相机镜头选型

- halcon标定

- 凌云视觉软件

- SciSmtCam

- VisionMaster

- 3d视觉/点云

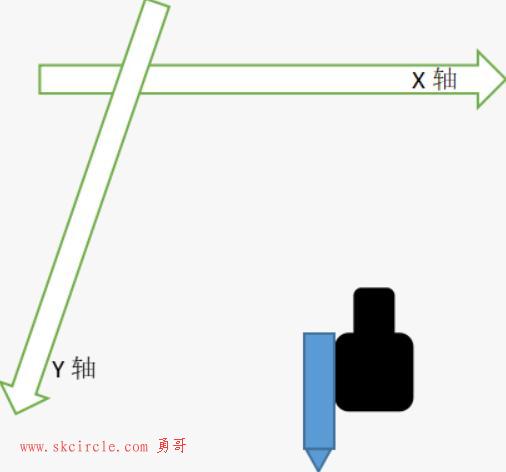

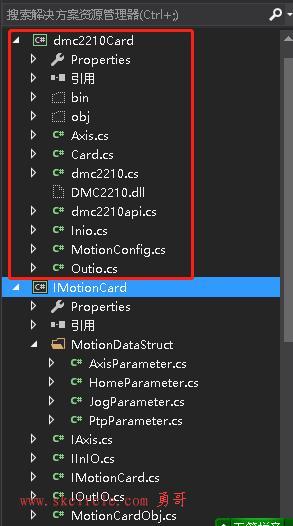

- 运动控制

- 标签列表

-

- 最新留言

-

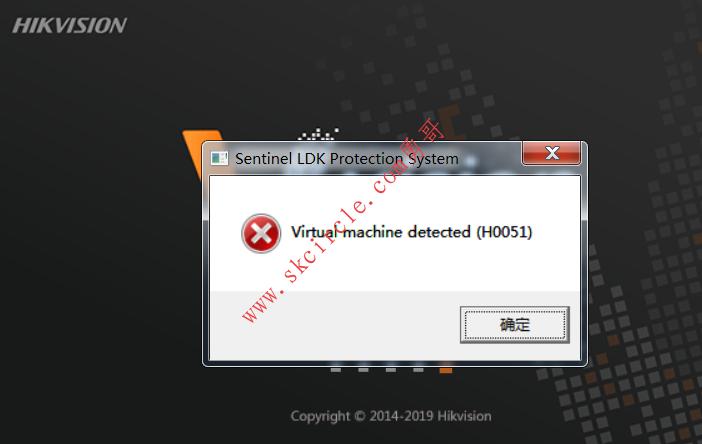

- 刚刚搜了一下,windows系统下也可以用ImDisk这个工具在内存中创建一个RAM磁盘,然后在里面安装软件

- 我觉得可以的,用Linux系统可以很方便地在内存中创建一个tmpfs文件系统,然后在里面安装软件

- 光度立体法对于线扫相机采图,好像不是很适用,采图太麻烦了

- 点太小了,我用笔画一个圆,然后视觉找圆中心,精度还可以

- 老哥, 优化一下界面排版吧, 图片挡住文字了

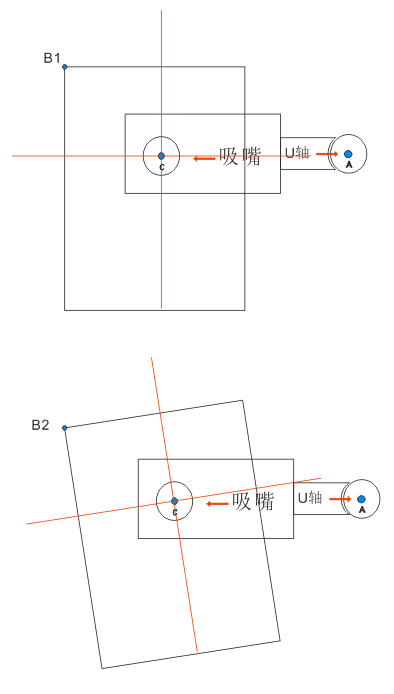

- 可以建工具坐标系,把旋转中心往C点接近这样距离是不是就变小了呢?这样是否可行呢?

- 勇哥 ,可以找你买 netMarketing高版本 使用 halcon19.11或者可以用halcon23.11的源码吗。

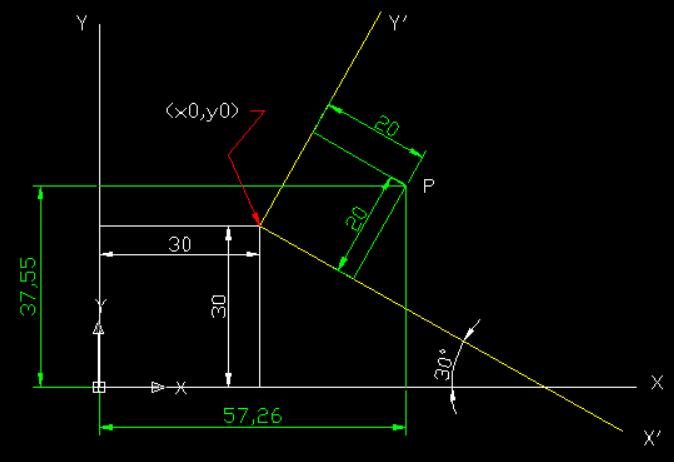

- Qxup=Xm1-Xbase-Qxc1-MxQyup=Ym1-Ybase-Qyc1-My勇哥,上诉公式的应该是分别加上Qxc1和Qyc1才对吧,Xm1-Xbase计算的是拍照偏差,如果再减去Qxc1和Qyc1贴合坐标是不是不合理呢?

- 勇哥能分享这个例子的源码吗

- 按这种方式封装确实可以,灵活

- 热门文章 | 热评文章 | 随机文章

-

- 文章归档

-

- 2025年10月 (11)

- 2025年9月 (5)

- 2025年8月 (13)

- 2025年7月 (14)

- 2025年6月 (21)

- 2025年5月 (13)

- 2025年4月 (1)

- 2025年3月 (7)

- 2025年2月 (9)

- 2025年1月 (11)

- 2024年12月 (21)

- 2024年11月 (40)

- 2024年10月 (23)

- 2024年9月 (5)

- 2024年8月 (26)

- 2024年7月 (52)

- 2024年6月 (64)

- 2024年5月 (55)

- 2024年4月 (13)

- 2024年3月 (19)

- 2024年2月 (7)

- 2024年1月 (6)

- 2023年12月 (20)

- 2023年11月 (30)

- 2023年10月 (3)

- 2023年9月 (1)

- 2023年8月 (7)

- 2023年7月 (3)

- 2023年6月 (2)

- 2023年5月 (3)

- 2023年4月 (1)

- 2023年3月 (10)

- 2023年2月 (35)

- 2023年1月 (8)

- 2022年12月 (66)

- 2022年11月 (52)

- 2022年10月 (11)

- 2022年8月 (7)

- 2022年7月 (9)

- 2022年6月 (18)

- 2022年5月 (4)

- 2022年4月 (6)

- 2022年3月 (2)

- 2021年10月 (4)

- 2021年9月 (26)

- 2021年8月 (2)

- 2021年7月 (60)

- 2021年6月 (15)

- 2021年5月 (11)

- 2021年4月 (3)

- 2021年3月 (12)

- 2021年2月 (23)

- 2021年1月 (38)

- 2020年12月 (69)

- 2020年11月 (88)

- 2020年10月 (50)

- 2020年9月 (9)

- 2020年8月 (16)

- 2020年7月 (42)

- 2020年6月 (63)

- 2020年5月 (59)

- 2020年4月 (87)

- 2020年3月 (79)

- 2020年2月 (144)

- 2020年1月 (41)

- 2019年12月 (82)

- 2019年11月 (122)

- 2019年10月 (34)

- 2019年9月 (13)

- 2019年8月 (16)

- 2019年7月 (46)

- 2019年6月 (2)

- 2019年5月 (17)

- 2019年4月 (45)

- 2019年3月 (59)

- 2019年2月 (12)

- 2019年1月 (25)

- 2018年12月 (41)

- 2018年11月 (78)

- 2018年10月 (80)

- 2018年9月 (28)

- 2018年8月 (13)

- 2018年7月 (75)

- 2018年6月 (37)

- 2018年5月 (1)

- 2018年4月 (1)

- 友情链接

Powered By Z-BlogPHP 1.7.2

Copyright Your skcircle.com Rights Reserved.

站长QQ:496103864 微信:abc496103864

少有人走的路

少有人走的路